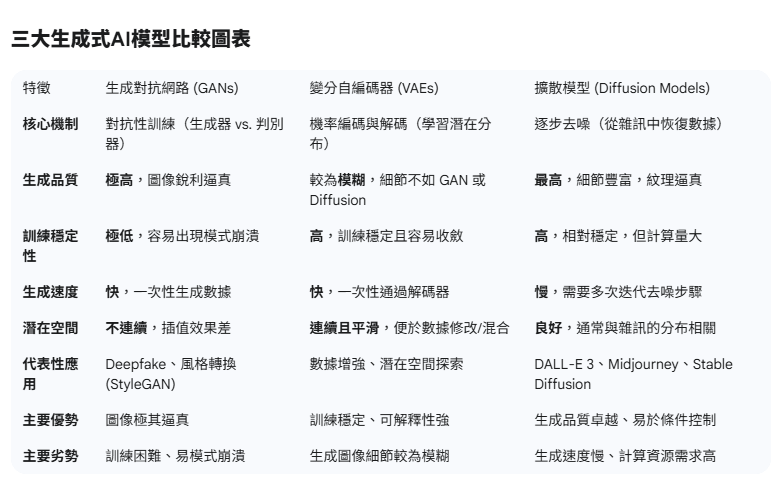

今天介紹的是目前生成式AI的領域的三大基石,雖然目標都是生成數據,但是它們採用了截然不同的運作機制和哲學。

1. 生成對抗網路(Generative Adversarial Networks, GANs)

GANs的核心概念是一種對抗性訓練(Adversarial Training),由兩個相互競爭的神經網路組成。

生成器(Generator): 負責從隨機雜訊中創造出新的、逼真的數據,試圖欺騙判別器。

判別器(Discriminator): 負責判斷書入的數據是真實的還是由生成器所創造的假數據,試圖揭穿生成器的騙局。

運作原理: 兩者不斷地相互對抗、學習和改進。隨著訓練的進行,生成器會越來越擅長創造逼真的假數據,而判別器也會越來越擅長識別這些假數據。當達到平衡時,生成器就能產生出足以亂真的內容。

優勢: 能夠生成極為銳利和逼真的圖像,尤其在圖像風格轉換、超解析度重建等方面表現優異。

劣勢: 訓練過程極不穩定,容易出現「模式崩潰(Mode Collapse)」,即生成器只會生成少數幾種圖像來欺騙判別器。

2. 變分自編碼器 (Variational Autoencoders, VAEs)

VAEs 基於機率模型(Probabilistic Model),它的目標是學習數據的底層機率分布,然後從這個分布中抽樣來生成新的數據。

**編碼器(Encoder):**將輸入的數據壓縮成一個低維度的「潛在空間(Latent Space)」中的機率分布(均值和標準差)。

**解碼器(Decoder):**從潛在空間中抽樣一個點,並將其還原(解碼)回高維度的數據空間(例如圖像)。

運作原理: VAEs 的訓練目標是讓解碼器能重建出原始輸入,同時確保潛在空間中的分布是平滑且連續的(通常是高斯分布)。這種設計使得我們可以在潛在空間中進行平滑的插值(Interpolation),從而生成介於兩個樣本之間的新數據。

優勢: 訓練過程穩定,潛在空間具有良好的可解釋性和連續性,便於進行數據的混合與修改。

劣勢: 生成的內容(特別是圖像)通常比 GANs 生成的更模糊,細節上不夠銳利。

3. 擴散模型 (Diffusion Models)

擴散模型是近年來在圖像和音訊生成領域取得巨大突破的技術,例如 DALL-E 3 和 Stable Diffusion 的核心技術。它採取了一個「去噪」的生成哲學。

運作原理: 擴散模型分兩個步驟:

正向過程(Forward Process): 逐步向原始圖像或數據中添加高斯雜訊,直到數據完全變成隨機雜訊。

逆向過程(Reverse Process): 訓練一個神經網路(通常是 U-Net)來學習如何逐步去除雜訊,從純雜訊中還原出原始的清晰圖像。

優勢: 生成的圖像品質極高,細節豐富且逼真,並且能夠穩定地處理複雜的、基於文字條件的生成任務(即 Prompt Engineering)。它們在訓練穩定性和生成多樣性方面優於 GANs。

劣勢: 生成過程需要大量的計算資源和時間,因為它涉及多次迭代的去噪步驟